ChatGPT は、AI テクノロジーの急速な進歩と可能性を象徴しています。人間のような対話を理解し、応答し、関与する能力により、顧客サービスからコンテンツ作成まで、さまざまなアプリケーションで重要なツールとなっていますそしてもっと。

ChatGPT 何度かの反復を経て、それぞれが前回よりも進化しました。このモデルは自然言語の生成と処理に革命をもたらし、新しいモデルはすべて以前のモデルよりもパフォーマンスが向上し、機能とパフォーマンスが大幅に向上しました。

GPT-3.5とGPT-4 OpenAIによって開発された次世代言語モデルです。GPT-3.5 は以前のバージョンに比べて大幅な改善を示していますが、GPT-4 はさらに進化し、さまざまな側面で注目すべき改善が導入されています。

GPT-3.5の機能と進化

GPT 3.5 は、人間のようなテキストを理解して生成するように設計されており、人間と AI の間のより自然で一貫した対話を可能にします。ChatGPT のこのバージョンは、前任者によって築かれた基盤の上に構築されており、言語の理解と生成機能が向上しています。

GPT-3 と同じ 1,750 億の広大なパラメーター フレームワークで動作しますが、2021 年 9 月までのデータでトレーニングされているという点で他と区別されます。このアップデートにより、GPT-3 と比較して、より最近の情報、傾向、開発をカプセル化することができます。 2020年までのデータで紹介。

GPT-3.5 では適応学習スキルが強化されており、動的なインタラクションをナビゲートし、複雑な問題解決タスクに取り組むことがより熟達します。

GPT-3.5ターボ

오픈 AIによる GPT-3.5 Turbo の最近の導入は、以前の GPT-3.5 バージョンの機能に基づいて、AI 言語モデルの大幅な進歩を示しています。このバージョンは速度と効率を重視して最適化されており、以前のモデルが直面していた重要な課題の 1 つである応答遅延に対処しました。

前世代の GPT-3.5 とは異なり、Turbo バージョンは機能が強化された点で際立っています。拡張された情報ストリームの処理に優れており、より複雑で長いデータ入力を管理するための優れた能力を示しています。

GPT-3.5 Turbo の注目すべき機能は、16,000 トークンのコンテキスト ウィンドウのサポートであり、1 つのインスタンスで考慮できる情報量が大幅に増加します。GPT-3.5 Turbo には、次のようないくつかの新機能も導入されています。JSONモード、同時関数呼び出しを実行する機能、および指示への遵守性の向上。

GPT 3.5 ターボの微調整

GPT-3.5 Turbo には微調整機能があり、特定のタスクや業界固有のニーズに合わせてカスタマイズを強化できるため、パフォーマンスが向上します。

この機能により、企業や開発者はモデルを独自の活動やプロジェクトに合わせてより正確にカスタマイズできるようになり、対象となるアプリケーションの効率と有効性が向上します。こうすることで、その応答を特定の要件に合わせることができます。

GPT-3.5ターボ-1106

GPT-3.5 Turbo ファミリのモデル gpt-3.5-turbo-1106 は、対話ベースのタスクに優れるよう設計されており、16,000 トークンのコンテキスト ウィンドウを備えています。この機能により、広範囲かつ複雑な会話データを処理する際のパフォーマンスが向上します。

価格に関しては、gpt-3.5-turbo-1106 は経済的に構成されており、入力の場合は 1,000 トークンあたり 0.0010 ドル、出力の場合は 1,000 トークンあたり 0.0020 ドルかかり、対話指向のアプリケーションにとって費用対効果の高いソリューションとなります。

GPT-3.5 ターボ命令

gpt-3.5-turbo-instruct モデルは、4,000 トークンのコンテキスト ウィンドウを備えた命令ベースです。この特別な設計により、詳細な指示が必要なタスクを効率的に処理できます。

価格に関しては、gpt-3.5-turbo-instruct の方がわずかに高く、正確な出力コストを維持しながら入力のコストは 1,000 トークンあたり 0.0015 ドルで、特殊な命令中心のアプリケーションにバランスのとれたオプションを提供します。

| モデル | 投入コスト (1,000 トークンあたりのドル) | 出力コスト (1,000 トークンあたりのドル) |

| GPT-3.5 | 指定されていない | 指定されていない |

| GPT-3.5ターボ-1106 | ¥0.145 | ¥0.287 |

| GPT-3.5 ターボ命令 | ¥0.215 | ¥0.287 |

OpenAI API コスト計算ツールを使用して、OpenAIのサービスの使用コストを見積もることもできます。OpenAPI コスト計算ツール、または詳細な価格情報を直接見つけることもできます。公式ウェブサイト。

GPT-3.5 TurboとGPT-4モデルの比較

OpenAIはGPTシリーズとして複数のモデルを提供しており、それぞれ異なるユーザーニーズに対応するように設計されています。これには、GPT-3.5 Turbo、GPT-4、そして最近ではGPT-4oシリーズが含まれます。GPT-3.5 Turboはスピードが特徴ですが、GPT-4モデルは特に要求の厳しいタスクにおいて、信頼性と創造性を強化しています。それぞれのモデルの具体的な内容に踏み込んで、その違いと強みをより包括的に理解していきましょう。

GPT-3.5 Turboの概要

GPT-3.5 Turboは、より新しく、より高速で、よりコスト効率の高いGPT-3.5シリーズの一部です。特に、優れた速度とコスト効率を実現するために発売されたGPT-3.5 Turbo-0125バージョンは、以前のバージョンに比べて大幅な改善が見られます。主な強化点には、小説程度の長さの記憶に相当する16Kのコンテキストウィンドウや、開発者向けのJSON出力の生成における信頼性の向上などがあります。

このバージョンは費用対効果に優れ、入力トークンは100万トークンあたり0.50ドル、出力トークンは100万トークンあたり1.50ドルです。さらに、最新バージョンでは、英語以外の言語のテキストエンコーディングに関連するバグが修正され、グローバルな開発者にとっての汎用性が向上しました。若干経済的であるにもかかわらず、特に指定されたフォーマットでは、言語タスクに優れた精度を提供します。

GPT 4の高度な機能

2023 年 3 月にリリースされた GPT-4 は、AI 機能の大幅な進歩を表しています。2021 年 9 月までのデータでトレーニングされたこの高度なモデルには、テキストと画像の入力を迅速に処理する独自の機能が導入されています。32,000 トークンの広範なコンテキスト ウィンドウを誇ります。

ただし、GPT-4 は現在、購入した人のみがアクセスでき、価格は 2,871 円に設定されている点を強調することが重要です。この要件により一般公開が制限されるため、プレミアム製品となります。

GPT-4 は、伝統的に言語リソースが限られていたラトビア語、ウェールズ語、スワヒリ語を含む、評価された 26 言語のうち 24 言語で英語能力において GPT-3.5 を上回りました。GPT-4 の重要な特徴は次のとおりです。

- ビジュアル入力処理のための高度な機能

- 方向制御機能の強化

- 創造性と共同能力の強化

視覚能力処理

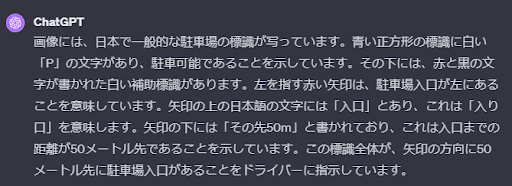

画像が提供されると、GPT-4 はそれを分析して説明的なキャプションを生成できます。これは、目に見える要素の単なる説明ではありません。モデルは、見ているものを文脈化して、画像内のシーンや主題についてのより深い理解を反映するキャプションを生成できます。

GPT-4の画像処理能力クロスモーダルな応答も可能になります。これは、視覚的な入力とテキスト情報を有意義に結び付けることができることを意味します。たとえば、外国語で道路標識の画像が表示されると、そのテキストを認識して転写し、別の言語に翻訳することができます。

ChatGPT はこの記号を次のように解釈します。

GPT 4 によるコンテンツモデレーション

GPT-4 は、広範なポリシー文書の微妙な点や規制を理解して適用できます。これらのポリシーの更新に迅速に適応し、より均一で一貫したラベル付けを保証します。

この能力は、AI が重要な役割を果たすデジタル プラットフォーム管理における明るい未来への道を開くものと見なされています。オンラインコンテンツのモデレート特定のプラットフォーム ポリシーに沿って。

GPT-4:信頼性と創造性をそのコアに

2024年3月に発表されたGPT-4は、より複雑で微妙なタスクを処理できる能力で際立っています。8192トークンのコンテクストウィンドウにより、このモデルはテキストの理解と視覚的コンテンツの分析の両方に優れています。GPT-3.5ターボとは異なり、GPT-4は画像を分析できるため、高度なマルチモーダル機能が必要なアプリケーションに最適です。

その高度な機能性を反映して、GPT-4の価格は入力トークン1,000個あたり0.03ドル、出力トークン1,000個あたり0.06ドルとなっています。ベンチマークによる性能比較では、GPT-4はGPT-3.5ターボモデルを大幅に上回る性能を示しています。例えば、GPT-4のMMLUベンチマークのスコアは86.4でしたが、GPT-3.5ターボのスコアは70.0でした。このようなベンチマークは、深い推論や問題解決能力を必要とするシナリオにおけるGPT-4の優れた能力を際立たせるものです。さらに、GPT-4はHellaSwag、GSM8K、HumanEvalなどの専門的な評価においてもGPT-3.5 Turboを上回り、複雑な推論や創造的なタスクに適していることを示しています。

GPT-4o Miniの紹介:コストと能力のバランス

GPT-4o Miniモデルは、2024年7月18日に発売され、能力と手頃な価格のバランスが取れたブレンドを提供することを目的としています。コスト効率に優れたバージョンであるにもかかわらず、GPT-4o Miniは、複数の評価基準においてGPT-3.5 Turboを上回る性能を発揮します。このモデルは、特に学術的なベンチマークにおいて優れた性能を発揮し、強化されたマルチモーダル推論と幅広いサポート言語を備えています。

GPT-3.5 Turboと比較すると、GPT-4o Miniは常に精度と関数呼び出し機能が優れており、強力かつコスト効率の高いモデルを求める開発者にとって理想的です。また、長文の文脈にも優れており、文脈の深い理解や長文の会話が必要なアプリケーションに最適です。

APIと価格におけるGPT-3.5 Turbo

GPT-3.5 Turbo-0125は、手頃な価格で堅牢な言語モデルを求める開発者向けに設計されています。出力の精度向上、信頼性の高いJSON生成、テキスト/音声入力との互換性などの機能強化が特徴です。API経由で利用可能なgpt-3.5-turbo-0125モデルは、16Kトークンコンテキストウィンドウを提供しており、GPT-4が提供するより高度な機能よりも速度と経済性を重視するプロジェクトに好まれる選択肢となっています。

価格面では、GPT-3.5 Turbo-0125はGPT-4およびGPT-4oモデルと比較して安価です。100万入力トークンあたり0.50ドル、100万出力トークンあたり1.50ドルで、これは前モデルの半額であり、品質を大きく損なうことなく幅広い用途に利用できます。

GPT-4 Turbo vs GPT-4o:コストと機能

GPT-4 Turboモデルは、アーキテクチャの観点ではGPT-4と類似しており、より高速な処理速度と大幅に高いレート制限を実現します。高性能なバリエーションとして導入されたGPT-4oは、GPT-4 Turboよりも手頃な価格で、入力トークン100万個あたり5ドル、出力トークン100万個あたり15ドルと、GPT-4 Turboのコストよりも50%低価格です。さらに、GPT-4oは128,000トークンの文脈ウィンドウと強化された視覚機能を提供し、複数の非英語言語をより効果的にサポートします。

GPT-4 Turboと比較すると、GPT-4oの利点には、処理速度の向上(2倍)と、GPT-4 Turboのトークンレートの5倍にあたる1分あたり最大1,000万トークンを処理できる能力が含まれます。これらの特徴により、GPT-4oは、言語理解、視覚的推論、高トークン制限アプリケーションのパフォーマンスを妥協することなく、費用対効果の高いソリューションを求めるユーザーにとってより優れた選択肢となります。

パフォーマンスベンチマーク:GPT-3.5 Turbo、GPT-4、GPT-4o

モデルを比較すると、いくつかの主要なベンチマークでそれぞれの強みが示されます。以下に、注目すべき指標をいくつか示します。

- MMLU(Massive Multitask Language Understanding):言語モデルが複雑な言語タスクを理解する能力を評価するベンチマーク。GPT-3.5 Turboは70点、GPT-4は86.4点、GPT-4oは両者を上回る88.7点。

- HellaSwag(文章完成ベンチマーク):GPT-3.5 Turboは85.5のスコアを達成し、GPT-4は95.3のスコアでさらに高い評価を得ました。これは、GPT-4が自然言語推論や文脈補完を伴うタスクにより適していることを示しています。

- HumanEval(コード生成評価):GPT-4は、テキストの記述からプログラムを合成するテストで67.0点を獲得しました。また、GPT-4o Miniも87.2点を獲得し、素晴らしい結果を示しました。

- GSM8Kと数学:数学的な問題解決では、GPT-4が優位性を示し、GSM8Kベンチマークで92.0、HumanEvalで67.0を獲得しました。一方、GPT-3.5 Turboは43.1と遅れをとりました。

このベンチマーク結果は、GPT-3.5 Turboは予算にやさしいものの、GPT-4とそのバリエーションであるGPT-4 TurboとGPT-4oは、高度な言語タスク、マルチモーダル推論、長文文脈の処理に優れていることを示しています。

GPT-4 のその他の効率的なモデル

GPT-4 には、さまざまなユースケースと効率要件に対応するいくつかのバリアントがあります。これらのモデルは、応答と言語処理の向上において GPT-4 の優れた機能を発揮し、入力コストと出力コストが異なるため、幅広いアプリケーションに適しています。

| モデル | 投入コスト(1,000トークンあたり) | 出力コスト (1,000 トークンあたり) |

| GPT-4 (8K) | 4.437円 | 8.873円 |

| GPT-4 (32K) | 8.873円 | 17.746円 |

| GPT-4-1106-プレビュー | 1.436円 | 4.307円 |

| GPT-4-1106-ビジョン-プレビュー | 1.436円 | 4.307円 |

GPT バージョンのモデル アーキテクチャ

GPT-3.5 と GPT-4 は両方ともトランスフォーマー アーキテクチャに基づいており、テキスト内の文脈上の依存関係をキャプチャするのに非常に効果的であることが証明されています。ただし、ChatGPT-4 はモデル アーキテクチャを改善し、パフォーマンス、トレーニング効率、およびスケーラビリティを強化するための新しい技術を組み込んでいます。

これら 2 つのモデルは、使用されるトレーニング データが異なります。GPT-3.5 は、さまざまなトピックやドメインにわたる、インターネット上の多様なテキストの大規模なコーパスでトレーニングされました。一方、GPT-4 はさらに広範で多様なデータセットの恩恵を受けており、言語と知識をより広範に理解することができます。

モデルのサイズに関しては、GPT-4 は通常 GPT -3.5 よりも大きく、より多くのパラメーターがあります。モデル サイズを増やすと、GPT-4 がデータ内のより複雑なパターンと関係を学習できるようになり、パフォーマンスの向上につながる可能性があります。

GPT 3.5 に対する GPT 4 の影響の増大を分析する

GPT-4 には、チャット GPT -3.5 と比較して多数のパラメータがあります。パラメーターが多いほど、モデルのレンダリング能力が向上し、言語のより細かい部分やニュアンスを捉えることができるようになります。

これにより、テキスト補完、言語翻訳、質問への回答など、さまざまな自然言語処理タスクのパフォーマンスが向上することがよくあります。

GPT 4 と GPT-3.5 の比較分析

GPT-3.5 と GPT-4 の違いはすぐには分からないかもしれません。ただし、タスクの複雑さが十分なしきい値に達すると、区別はより創造的で信頼できるものになります。

GPT-4 は、GPT-3.5 と比較して、優れた信頼性、創造性、および微妙な指示を解釈して応答する高度な能力を示します。

| 特徴・側面 | GPT-3.5 | GPT-4 |

| トレーニングデータ | 2021 年 9 月までのデータに基づいてトレーニング済み | より広い範囲をカバーする、より最近のデータに基づいてトレーニングされています |

| コンテキストウィンドウ | 通常は最大 16,000 個のトークンをサポートします | 最大 32,000 トークン以上をサポート |

| パフォーマンス | 言語処理タスクで非常に効果的 | 複雑なタスクの効率と精度がさらに向上 |

| 信頼性 | 幅広い作業に信頼性を発揮 | 特に微妙なシナリオにおいて信頼性の向上を実証 |

| 多言語機能 | 複数の言語で優れたパフォーマンスを発揮 | リソースが少ない言語を含む、より幅広い言語で優れたパフォーマンスを実現 |

| ビジュアル入力処理 | 主にテキストベース | テキストと画像の両方の入力を処理可能 (該当する場合) |

| 命令の取り扱い | 指示をよく理解し、従う | 複雑で微妙な指示を解釈し、応答する高度な能力を示します。 |

| 操縦性 | スタイルとコンテンツの標準コントロール | 出力をより正確に制御するための強化されたステアビリティ機能 |

結論

GPT-4 は、OpenAI言語モデルの進化。ChatGPT-4 は、モデル アーキテクチャ、トレーニング データ、サイズ、パラメーター、微調整機能が改善され、言語理解と生成タスクのパフォーマンスが向上しました。GPT-3.5 はすでに注目に値する成果でしたが、GPT-4 は次世代言語モデルの新しい標準を設定します。

よくある質問 (FAQs)

GPT-4 はあらゆる画像を処理できますか? それとも制限がありますか?

GPT-4 は、画像を処理し、関連するテキスト出力を提供するように設計されています。ただし、そのパフォーマンスは画像の複雑さと明瞭さによって異なり、受けた特定のトレーニングによっては制限がある場合があります。

GPT-3.5 または GPT-4 を使用する際に倫理的な考慮事項はありますか?

倫理的な考慮事項には、AI の応答によって偏見、誤った情報、または有害なコンテンツが伝播しないようにすることが含まれます。OpenAIは、開発者がモデルの倫理的な使用を奨励するために、コンテンツ モデレーション ポリシーとガイドラインを実装しました。

開発者はプロジェクトで GPT-3.5 および GPT-4 にどのようにアクセスできますか?

開発者は、OpenAIの API サービスを通じて GPT-3.5 および GPT-4 にアクセスできます。アクセスするには、使用ポリシーに従う登録が必要な場合があり、GPT-4 の場合は購入またはサブスクリプション料金がかかる場合があります。

GPT-3.5 または GPT-4 の実装に関して、OpenAIはどのようなサポートを提供しますか?

OpenAIは、GPT モデルの実装における開発者をサポートするドキュメント、チュートリアル、コミュニティ フォーラムを提供します。また、API の直接サポートも提供しており、開発者がこれらのモデルをアプリケーションに統合するのを支援できます。

特定のタスクに合わせて GPT-3.5 または GPT-4 を微調整するプロセスは何ですか?

微調整には、特殊なデータセットでモデルをトレーニングして、応答を特定のトピックやスタイルに適応させることが含まれます。開発者は OpenAIの微調整サービスを使用できます。これには、データセットを準備し、API を介して微調整ジョブを実行する必要があります。

アプリケーションを GPT-3.5 の使用から GPT-4 に移行することはできますか?

はい、移行は可能です。開発者は、互換性を確保し、GPT-4 の改善点を最大限に活用するために、機能の違いと API の変更を確認する必要があります。新しいモデルに対応するためにコードを調整し、場合によってはシステムを再トレーニングする必要があるかもしれません。