人工知能 (AI) は、学習、意思決定、問題解決、自然言語の理解など、一般に人間の知能を必要とするタスクを実行できます。彼らは膨大な量のテキスト データでトレーニングを受けており、言語のパターン、構文、文脈、ニュアンスを学習しているため、フレーズ内の次の単語を予測したり、一貫した文章を作成したり、言語を翻訳したりすることができます。

機械学習、深層学習、ルールベース システムの急速な進歩はすべて、言語モデルの進化に貢献しており、言語モデルは今までよりもはるかに多くの機能を備えています。GPT (Generative Pre-trained Transformer) などのトランスフォーマー ベースのモデルは、自然言語処理タスク大量のデータセットを効率的に処理し、長いテキスト距離にわたるコンテキストを理解することによって。

OpenAI の生成事前トレーニング済みトランスフォーマーの最新バージョンである GPT-4 は、人工知能言語モデルにおける大きな進歩を表しています。GPT-4 は、前世代よりもさらに大規模なデータセットと高度なアルゴリズムを備えた、これまでにない精度と繊細さで人間の言語を理解して生成できる、最も先進的な人工知能モデルです。

GPT-4 は以前のバージョンからの進歩であり、会話型 AI、コンテンツ制作、教育から法的分析、医療診断、クリエイティブ アートなどのより複雑な業務に至るまで、さまざまなアプリケーション向けの革新的なツールです。

GPT-4のマルチモーダルな能力

マルチモーダル機能により、GPT -4 のリリースは AI 言語モデルの開発における革命的な変化を示しました。これらの機能のおかげで、GPT-4 はテキストとビジュアル コンテンツを理解して生成し、情報処理とさまざまな通信チャネルの間のギャップを埋めることができます。

ビジュアルコンテンツの理解と生成

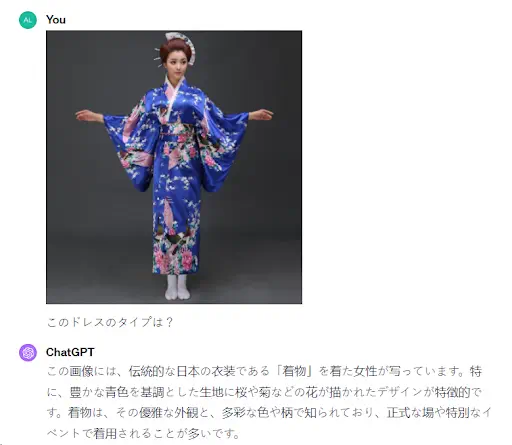

GPT-4 の際立った機能の 1 つは、視覚的なコンテンツを理解して生成する機能です。これは、画像を解釈し、説明を作成し、テキストの説明に基づいて画像を生成し、テキストとグラフィック情報の間のギャップを埋めることができることを意味します。

この機能は、Web サイトの画像に有益な代替テキストを提供することにより、アクセシビリティを向上させ、スクリーン リーダーを使用してコンテンツにアクセスする視覚障害のあるユーザーのオンライン エクスペリエンスを向上させます。

たとえば、熱帯雨林の保護に関する記事と、アマゾンの熱帯雨林の多様な生態系の目を引く写真が掲載されている Web サイトを想像してください。

この写真には、緑豊かな植物、数種の動物、地形を横切る川が生き生きと描かれています。この画像には、視覚障害のあるユーザーのアクセシビリティを向上させるために、GPT-4 によって生成された説明的な代替テキストが含まれている場合があります。

代替テキストの例:「アマゾンの熱帯雨林の活気に満ちた生態系。明るい空の下にうっそうとした緑の葉、自然の生息地にいる鳥、サル、ジャガーなどの多様な野生動物、緑豊かな環境を反映して風景を蛇行する清流が特徴です。」

この代替テキストは、徹底的かつ鮮明な説明を提供することで、視覚障害のあるユーザーが画像を視覚化するのに役立ちます。

これにより、代替テキストにより、画像を見る能力に関係なく、すべてのユーザーが画像の内容と熱帯雨林保護の重要性を理解できるようになります。このアプローチでは、背景を提供することでユーザー エクスペリエンスを向上させ、Web コンテンツをより包括的にします。

さらに、GPT-4 の機能は、視覚的な質問への回答(VQA) はその有用性を高めます。高度な言語処理と視覚データ分析を融合することで、画像に関する質問に答えることができ、テキスト情報とグラフィック情報の把握を必要とする対話を容易にします。

ここで、GPT-4 は、被写体の位置、色、ドレスのパターンなど、画像の視覚的要素を検査して説明テキストを作成しました。

この 2 つの機能により、ユーザーは画像について正確な質問をし、洞察力に富んだ文脈に関連した回答を得ることで、より豊かでより奥深い方法でコンテンツと対話できるようになります。

これらの機能を組み合わせると、デジタル コンテンツのアクセシビリティとインタラクティブ性の向上において大きな前進となり、AI がテキスト認識と視覚認識の間のギャップを埋める創造的な方法を実証します。

のギャップを埋める創造的な方法を実証します。

ビジュアルコンテンツとのインタラクティブ性

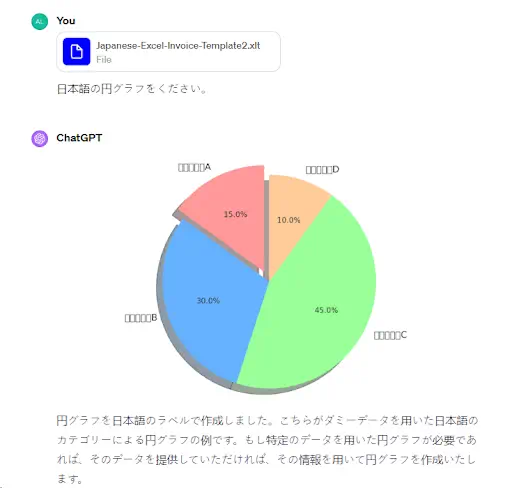

GPT-4 は、写真、図、チャートなどの視覚データを分析し、洞察と説明を提供したり、視覚入力を補完するテキストベースのコンテンツを生成したりできます。

GPT-4 によるデータ視覚化の導入は、分析とナレーションに大きな変革をもたらします。複雑なデータの構造と意味を完全に理解できるため、重要な傾向や異常を強調表示するグラフやチャートを作成し、ユーザーがパターンを迅速に特定することが容易になります。

GPT-4 は単なるチャートのジェネレーターではありません。また、テキストによる説明と視覚的なコンポーネントを組み合わせてインフォグラフィックを生成し、データのストーリーをよりよく伝える画像を作成することもできます。

このテキストと画像の合成は、エンゲージメントと明瞭さが重要なプレゼンテーション、レポート、デジタル コンテンツにとって非常に貴重です。

さらに、GPT-4 の動的データ解釈機能により、新しいデータがリアルタイムで受信されると、視覚化が最新の状態に保たれます。

この機能により、ユーザーは常に最新の分析情報にアクセスできるようになり、ダッシュボードやライブ レポートの監視など、最新の情報の表示が必要なシナリオで特に役立ちます。

GPT-4 は、データの視覚化を、静的で手間のかかるプロセスではなく、自動化されたインタラクティブなリアルタイムの芸術形式に変換します。

GPT-4 Turboシリーズの一部であるGPT-4 Visionは、最大128,000トークンの優れたコンテクストウィンドウを特徴としています。この拡張されたコンテクストウィンドウにより、モデルはより大きな会話、複雑な文書、またはテキストと画像データの混合を処理することができ、詳細かつ多面的なタスクに非常に適しています。最大出力制限は4,096トークンであり、複雑な視覚的およびテキストデータを処理しながら包括的な回答を保証します。

価格面では、GPT-4 Vision(プレビュー版を含む)は使用ベースの価格モデルを採用しています。費用は、入力トークン100万単位あたり10ドル、出力トークン100万単位あたり30ドルで、gpt-4-vision-previewのようなモデルに適用されます。さらに、ChatGPT Plusのサブスクリプション(月額20ドル)では、ビジョン機能を備えたGPT-4へのアクセスも提供され、視覚分析、データ抽出、コンテンツ作成など、幅広いユースケースにこれらの高度な機能をお手頃な価格でご利用いただけます。

GPT-4 は以前のモデルとどう違うのですか?

GPT-4 は他とは一線を画しています。以前のモデルより複雑で強力な、事前に訓練された生成トランスとしての地位を強調するいくつかの革新的な機能を備えています。GPT-4 は、より重要で複雑なアーキテクチャにより、パラメータが少ない GPT-3.5 よりも際立っています。

この以前の機能強化により、言語の微妙な点や文脈をこれまでにないほど理解できるようになり、より一貫性、ニュアンス、文脈認識が向上した出力が得られます。

さらに、GPT-4 はマルチモーダル機能を追加することで大幅に進歩し、テキスト形式とビジュアル形式の両方の入力を解釈し、それに応じて応答を生成できるようになります。この機能により、GPT-3.5 のテキストのみの処理が大幅に変更され、テキスト情報処理と視覚情報処理の組み合わせを必要とするアプリケーションに新たな機会が提供されます。

複雑な指示に従い、人間の目的により密接に一致する出力を生成する GPT-4 の能力は、技術的および芸術的な執筆を含むさまざまな仕事への適応性を際立たせるもう 1 つの特徴です。

偏見や有害な情報の作成に対する管理が強化されるとともに、AI の安全性と倫理が大幅に進歩します。GPT-4 は、繰り返しが減り、関連性が高まり、与えられた情報がより正確に表現され、品質が大幅に向上した出力を生成します。

GPT-3.5 でカバーする必要がある可能性のある内容を含む、より広範な最新の知識ベースにより、より正確でタイムリーな回答を提供できます。

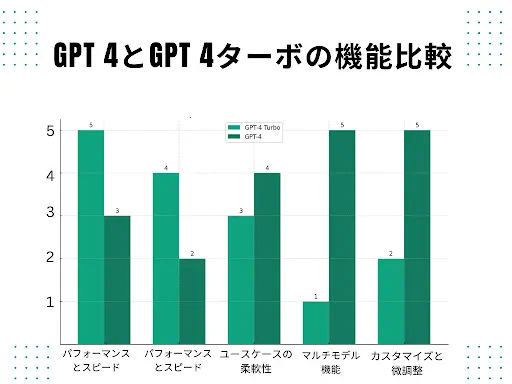

パフォーマンスの比較: GPT-4 vs GPT-4 Turbo

OpenAI の高度な言語モデルは、GPT-4 Turbo および GPT-4 で利用できます。それぞれが、異なるユースケースとパフォーマンス基準を満たすことを目的としています。

GPT-4 Turboは、スループットが向上し、応答時間が短縮されるように設計されているため、チャットボット、仮想アシスタント、対話型アプリケーションなどのリアルタイム アプリケーションを処理できます。

より経済的になることも目的としています。これにより、企業や開発者は、完全な GPT-4 モデルに関連する高い料金を支払うことなく、強力な AI 機能を使用できるようになります。

ただし、GPT-4 はより高い柔軟性と微調整オプションを提供し、開発者がモデルを特定のジョブやセクターに合わせてより正確にカスタマイズできるようになります。GPT-4 はその柔軟性により、法的分析、医学研究、クリエイティブな執筆などの特定の用途に最適です。

タスクの正確なニーズによって、どの ChatGPT モデル (GPT-4 Turbo または GPT-4) を選択するかが決まります。迅速なリアルタイム通信が不可欠なアプリケーションで速度、効率、手頃な価格を求める開発者にとって、GPT-4 Turbo は優れたオプションです。ただし、多機能の対話、広範なコンテキスト知識、およびより高度なカスタマイズを必要とするアプリケーションには、GPT-4 の方が適しています。

さらに、GPT-4 はさまざまな言語をサポートできるため、言語的背景を越えてアクセシビリティとユーザー エクスペリエンスが向上し、世界中の視聴者にとっての有用性が向上します。

さらに、GPT-4 の微調整機能は GPT-3.5 よりも優れているため、研究者や開発者は特定の用途に合わせてモデルをより自由にカスタマイズできます。この程度のパーソナライゼーションにより、GPT-4 の機能をさまざまなユースケースや分野の要求に正確に適応させることが容易になり、よりインテリジェントで適応性のある人工知能ツールとしての地位が高まります。

GPT-4 vs GPT-4o

GPT-4からGPT-4oへの移行は、テキスト、画像、音声、動画を網羅するマルチモーダル機能の大幅な進歩を特徴とし、人工知能における著しい進化を表しています。GPT-4oは、応答時間が平均5秒からわずか320ミリ秒に短縮され、速度と汎用性が大幅にアップグレードされました。このレスポンスタイムの大幅な改善は、ユーザーエクスペリエンスを大幅に向上させ、よりスムーズで即時的なやりとりを実現します。これは、リアルタイムアプリケーションにとって非常に重要なことです。

スピードの面だけでなく、GPT-4oは、中国語、イタリア語、日本語、ポルトガル語など、複数の言語を扱う際にも優れた能力を発揮し、その関連性と有用性を世界規模で拡大しています。また、このモデルは、さまざまな声色を生成し、笑い声や歌声など人間のようなニュアンスを模倣できる高度な音声機能も統合しており、応答の信憑性を高めています。

言語と音声に加え、GPT-4oは視覚処理にも優れ、複雑な視覚データの理解と分析において、その前身を凌駕しています。この強化された能力により、画像を扱う際に文脈に即したより適切な応答が保証され、GPT-4oはマルチメディアコンテンツを含むタスクにもより適応するようになりました。包括的な言語理解力を評価するMMLUベンチマーク評価では、GPT-4oは88.7%という素晴らしいスコアを達成しました。これは、GPT-4の86.6%というスコアを上回るものです。

この違いは、GPT-4oの認知能力と複雑な推論タスクにおける全体的なパフォーマンスの向上を際立たせています。全体として、GPT-4oはGPT-4から大幅に進歩しており、異なるモダリティにわたってより高速で、より繊細で、より正確な処理を実現しており、教育から異文化コミュニケーションまで、さまざまな用途に欠かせないツールとなっています。

GPT-4oとキャンバス

2024年10月3日に導入されたGPT-4o Canvasは、人工知能に新たなコラボレーションの次元をもたらし、ユーザーがChatGPTとやりとりして文章やプログラミングのタスクを行う方法を強化します。この革新的な機能は、ChatGPTインターフェース内に専用のコラボレーションワークスペースを立ち上げ、ユーザーが同時にプロジェクトに取り組むことを可能にします。

現在ベータ版のGPT-4o Canvasは、ChatGPT Plus、Team、Enterprise、Eduのユーザーが利用でき、教育およびプロフェッショナル環境におけるコラボレーションを促進するというOpenAIの取り組みを反映しています。 Canvasを使用すると、複数のユーザーが同じ文書でリアルタイムに作業でき、AIによる提案や修正のメリットを享受しながら、自分の入力が共有ワークスペースにシームレスに統合されることを確認できます。

GPT-4o Canvasの重要な特徴のひとつは、的を絞ったフィードバックを提供できることです。ユーザーは支援が必要な特定の領域をハイライトすることができ、それに応じてCanvasが分析に焦点を当て、正確な推奨事項を提供します。この機能は、テキストの改善、コードのデバッグ、プロジェクト全体の品質向上に特に役立ちます。

さらに、Canvasには、テキストの長さの変更、読みやすさの調整、コードの改善に役立つインラインコメントの追加など、一般的な操作を簡素化するショートカットのセットが含まれています。コーディングに関しては、ユーザーはコードを他の言語に変換したり、ログやコメントを挿入したり、エラーを効率的に解決したりすることができます。これにより、GPT-4o Canvasは共同作業のためのツールであるだけでなく、生産性と創造性を向上させる貴重なアシスタントとなり、人々が一緒に文章を書いたり、プログラムを作成したりする方法を変えることができます。

GPT-4o 対 GPT-4o mini

GPT-4o と GPT-4o Mini は、高度なAI機能を提供しながら、異なるニーズやシナリオに合わせてそれぞれ調整された、OpenAIのoシリーズにおける2つの専門バージョンです。GPT-4o は、テキスト、画像、音声、動画を含む複雑なマルチモーダルタスク用に設計された本格的なバージョンです。複雑な推論タスクに優れ、さまざまな言語の理解能力も強化されているため、グローバルなコミュニケーションや、ヘルスケアや物理学などの分野における高度な研究に非常に適しています。 幅広い機能セットと洗練されたマルチモーダル機能を備えたGPT-4oは、特に、高い精度、微妙なニュアンスを表現できる言語能力、包括的なマルチメディア分析を必要とする用途に適しています。

一方、GPT-4o Mini はより経済的なバージョンとして設計されており、GPT-4o のコアとなる利点を提供することに重点を置きながら、計算コストを削減しています。具体的には、GPT-4o Mini は GPT-4o フルバージョンと比較して80%のコスト削減を実現しており、小規模な企業、教育ユーザー、個人開発者にとって利用しやすいオプションとなっています。複雑な推論タスクを処理する能力を維持しながら、GPT-4o Miniは、よりシンプルなプログラミングタスク、教育目的、基本的な科学的問い合わせなど、マルチモーダル機能のフルレンジを必要としないシナリオに最適化されています。

これにより、GPT-4o Miniは、GPT-4oに関連する高いコストを負担することなく高度なAI機能を活用したいと考えている人にとって現実的な選択肢となり、高度なAI技術の恩恵を受けられるユーザーの範囲を拡大します。両モデルはChatGPT PlusとTeamの購読者に提供されており、将来的には無料プランのユーザーを含むより幅広いユーザーが利用できるようになる予定です。

GPT-4 はテクノロジーとビジネスを進歩させます

GPT-4 は人間の応答に似た応答を理解して提供できるため、企業はより高度で効果的なカスタマー サポート ボットを開発できる可能性があります。これらの AI を活用したシステムは、クエリに応答して 24 時間体制で支援を提供し、運用効率と消費者の幸福度を向上させます。

ライターは GPT-4 を使用して、文脈に関連した優れた文章コンテンツを大量に作成できます。これらの機能を使用すると、マーケティング担当者、出版社、教育者は、多様なコンテンツをより迅速かつ効果的に作成できるようになります。

さらに、ビジネス分析のために大量のデータを分析したり、レポートを作成したり、大量のテキスト データを分析したり、洞察を抽出したりすることもできます。企業はこのテクノロジーを使用して、消費者の意見、市場動向、業務パフォーマンスに対する認識を向上させることができます。

GPT-4を利用する場合の料金プラン

GPT-4の価格体系複雑な AI 機能をより経済的な価格で提供するために改訂されました。この変更は、革新的な AI テクノロジーのアクセシビリティの向上に対する OpenAI の取り組みを示しています。

| モデルコンテキストの長さ | プロンプトトークン (1,000 トークンあたり) | サンプリングされたトークン (1,000 トークンあたり) |

| 128k コンテキスト | 1.3円 | 3.9円 |

| 8Kコンテキスト | 3.9円 | 7.8円 |

| 32k コンテキスト | 7.8円 | 15.6円 |

OpenAI は、GPT-4 の機能を活用したい開発者、研究者、企業に、コンテキストの長さとトークンの使用量に応じて価格を変更することで、ニーズと予算に対応できる柔軟でスケーラブルな価格体系を提供したいと考えています。

GPT-4 は技術の進歩を超えて、生産性を向上させ、いくつかの業界に扉を開く企業イノベーション アクセラレータです。企業は、GPT-4 のパワーを利用してデジタル曲線の先を行くことで、顧客や業界の変化するニーズに合わせて AI を使用できます。

課題と倫理的考慮事項

責任ある使用を確保し、潜在的な危害を軽減するには、GPT-4 などの高度な AI モデルの導入と使用に関連するいくつかの問題と倫理的問題に対処する必要があります。こうした問題は複雑で、トレーニング データの偏りからプライバシーや雇用に対する AI の影響まで多岐にわたります。

高度な GPT-4 を誤用すると、虚偽の情報、個人のなりすまし、または有害なコンテンツの自動作成が発生する可能性があります。AI の利点を維持しながら悪用を防ぐには、慎重な検討が必要です。

関係者は、AI テクノロジーの進化によってもたらされる複雑な問題と倫理的考慮事項を、特に GPT-4 のようなモデルで慎重に管理する必要があります。重大な問題は、トレーニング データに生来のバイアスが存在することであり、その結果、既存の偏見を強化または拡大する AI 出力が生成され、平等性と公平性が損なわれる可能性があります。

これらのバイアスを軽減するための継続的な取り組みが必要であり、公正なテストとさまざまなトレーニング データセットを含む多様な戦略が必要です。AI のトレーニングに使用される大量の個人データによっても、同意と情報の倫理的使用に関する懸念が生じ、プライバシーに関する重大な懸念が生じます。

よくある質問

GPT-4 は、家庭教師や学習教材の作成などの教育目的に使用できますか?

GPT-4 は、さまざまな科目の生徒の指導、パーソナライズされた学習教材の作成、インタラクティブな学習体験の作成など、教育目的に使用できます。

GPT-4 は、処理するデータのプライバシーとセキュリティをどのように確保しますか?

OpenAI は、GPT-4 によって処理されるデータのプライバシーとセキュリティを確保するために、いくつかの対策を実装しています。これには、データの匿名化、安全なデータ処理プロトコル、プライバシー規制への準拠が含まれます。

GPT-4 はさまざまな言語や方言をどのように処理しますか?

GPT-4 は、複数の言語と方言を含む多様なデータセットでトレーニングされており、多くの言語のテキストを高精度で理解して生成することができます。また、言語間で翻訳したり、異なる方言に適応したりすることもできます。

GPT-4 の悪用を軽減するために OpenAI はどのような措置を講じていますか?

OpenAI は、GPT-4 の悪用を軽減するために、有害な情報や誤解を招く情報の生成を防ぐコンテンツ フィルター、悪用パターンを検出して対処するための使用状況の監視、責任ある使用のためのガイドラインなど、いくつかの安全対策を実装しています。

GPT-4o Miniは画像、動画、音声の処理も可能ですか?

現時点では、GPT-4o Miniはテキストと画像の処理が可能です。将来的には動画や音声の入力にも対応できるよう機能拡張を計画しており、さらに汎用性を高める予定です。

GPT-4o Miniの性能は他のモデルと比較してどうですか?

GPT-4o Miniは、Llama 3 (8B)、Claude 3 Haiku、GPT-3.5 Turboなど、多くの同等のモデルを処理の質と速度の両面で上回っています。Gemini 1.5 Flashは若干速く結果を生成するかもしれませんが、GPT-4o Miniはより質の高いアウトプットを提供することで知られており、高度なAIアプリケーションの有力な候補となっています。

GPT-4oはGPT-4よりも優れているのでしょうか?

GPT-4oは、英語のテキストやコードの処理において、ChatGPT-4 Turboと肩を並べます。また、英語以外の言語については、さらなる機能強化が図られています。GPT-4よりも高速に動作し、視覚および音声データの処理では優れたパフォーマンスを発揮します。

GPT-4o APIの使用方法は?

GPT-4oモデルは、OpenAIのチャット補完APIを通じてアクセスでき、以前のバージョンとの後方互換性を維持することでシームレスな統合を実現し、開発者とユーザーにとっての使いやすさを確保しています。