生成型事前学習型トランスフォーマ(GPT)シリーズは、近年、言語モデルの分野で最も注目すべき進歩のひとつとして登場しました。これらのモデルは、幅広いアプリケーションにおいて、人間のようなテキストを理解、生成、操作することを機械に可能にすることで、自然言語処理(NLP)を大幅に変革しました。初期のバージョンであるGPT-4oは、GPT-5やGPT-5.1といった強力でより高性能なモデルへと進化を遂げました。OpenAIがこれらを導入した際、以前のモデルはすべて廃止されました。しかし現在では、有料のChatGPTユーザーのみが「レガシーモデル」にアクセス可能であり、そこではGPT-4、GPT-4o、o3、o4-mini、GPT-4.1、およびGPT-5.1の全バリエーションを利用できます。

大規模なスケール、ディープアーキテクチャ、高度な文脈理解を特徴とするGPTモデルは、多くのNLPタスクに革命をもたらしました。これらのタスクには、質問応答、クリエイティブなコンテンツ生成、言語翻訳、テキスト要約などが含まれますが、これらに限定されません。その成功の秘訣は、何十億ものパラメータで構成される大規模なデータセットを用いた広範な事前トレーニングにあります。これにより、これらのモデルは、人間の言語における微妙な関係性や構造を捉えることができるようになりました。時が経つにつれ、GPTモデルの各反復は、効率性、理解力、複雑な推論を行う能力において大幅な改善をもたらしました。

こうした進歩により、GPTファミリーはAIが達成できることの限界を押し広げ、従来のNLPタスクだけでなく、クリエイティブな分野でも顕著な貢献を果たし、ユーザーとの対話を強化し、会話エージェントを開発し、コンテンツ作成を支援しています。これらのモデルは、幅広い業界の中心的な存在となり、開発者、研究者、企業がAIの力を活用して現実世界のさまざまな用途に役立てられるようになっています。

ChatGPTの上級GPTモデル

ここでは、進化、価格、性能に焦点を当てながら、高度なGPTバージョンを簡単に紹介する。

GPT-3

GPTモデルシリーズの第3バージョンはGPT-3と呼ばれている。このソフトウェアは、まるで人間が書いたかのように思えるほど独創的な段落を作成することができる。GPT-3モデルは、アクセス制限付きのクラウドベースのAPIからもアクセスできる。ユーティリティを使用するにはアクセスが必要だ。リリース以来、いくつかの魅力的なアプリケーションが生み出されている。GPT-2よりも100倍大きく、1750億以上のパラメーターを持っている。5,000億語のデータセットを使って訓練されている。

GPT-2は5,000億語のデータセット(Common Crawlとしても知られる)を使って学習される。このデータセットは、広範なインターネットとコンテンツ・リポジトリから収集される。その他、コード・スニペットの記述、迅速なアクティビティ、基本的な演算問題の解決など、予想外の能力も備えている。

GPT-3には、Ada、Babbage、Curie、Davinciの4つの言語モデルがある。最も強力なのはChatGPTで利用されているDavinciだが、他の3つも感情分析や要約オーサリングのような簡単な仕事にはまだ使える。コストは1,000トークンごとに決定される。50Kトークンを使うごとに、Davinciモデルに従って1ドルを支払うことになる。

GPT-3の4つのモデルは異なる価格帯を含んでいる。GPT-3のコストは、基本モデルのAdaの場合、1000トークンあたり0.0004ドルから始まる。同様に、Davinciモデルには1Kトークンあたり0.0300ドルでアクセスできる。

GPT-3.5

GPT-3.5シリーズは、GPT-3と同様にGPT-3から派生したモデルである。 GPT-3.5の特徴は、人間の価値観に基づいた一定のルールに従っていることで、強化学習と人間のフィードバック(RLHF)というプロセスによって統合されている。主な目標は、毒性を減らし、生成される出力の真実性を優先し、モデルをユーザーの意図により近づけることである。この進化は、言語モデルのモラルと責任ある適用を改善し、より信頼できる安全なユーザー体験を提供するための意図的な試みである。GPT-3.5は、GPTシリーズのGPT-3とGPT-4の間に位置する。GPT-3.5が2021年初頭に初めてリリースされたとき、前モデルのサイズ、パフォーマンス、適応性を大幅に改善した。

GPT-3.5 Turbo

OpenAIは、前身であるGPT-3.5を大幅に改良したGPT-3.5 Turboをリリースしました。2023年12月11日より、すべてのユーザーは自動的にこの改良版に移行します。主な強化点には、より大規模なデータ分析機能、デフォルトの16Kコンテキストウィンドウ、JSONモード、同時関数呼び出し、より優れた指示追跡機能などがあり、より強力で多用途になっています。

GPT-3.5 Turboはコスト効率に優れ、トークンコストが削減されているため、大量使用に最適です。また、特定の業界向けに微調整をサポートしており、企業は独自のニーズに合わせて応答をカスタマイズすることができます。

GPT-3.5 Turboファミリーには、対話(16K文脈)用の「gpt-3.5-turbo-1106」と、指示(4K文脈)用の「gpt-3.5-turbo-instruct」の2つのモデルがあります。最新のモデルであるGPT-3.5-Turbo-0125は、より高速で正確な応答を提供し、英語以外の機能呼び出しに関連するバグを修正しています。生成コストが50%削減され、出力コストも25%削減されているため、開発者にとって経済的な選択肢となっています。

また、OpenAIは旧モデルを「レガシー」と指定し、開発者は新しいエンドポイントに移行すべきであることを示しています。複雑なタスクにはGPT-4の方がより適していますが、GPT-3.5 Turboは現在、強化された機能を備えた強力で手頃な代替手段となっています。GPT-3.5 Turboは現在、ChatGPTインターフェースのGPT-4o miniを指していますが、開発者はAPIで利用できます。

GPT-4

GPT-4は、スケールは異なるものの、同等のトランスフォーマーのアーキテクチャ・パラダイムに依存しているが、両者には多くの共通点がある。トランスフォーマーモデルが使用するエンコーダー・デコーダーアーキテクチャには、入力シーケンスのパターンを識別し、複雑な相関関係を捉える役割を担う自己注意モジュールが含まれている。シーケンスはエンコーダーによって処理され、トランスフォーマーの出力では、デコーダーがエンコーダーの出力を作成されたシーケンスに変換する。逆に、OpenAIはGPT-4のトレーニング方法について、技術的な詳細をすべて公開していた前身とは対照的に、最小限の詳細しか提供していない。スケーリングに関しては、GPT-4のアーキテクチャーは前任者よりも大きく改善されている。

OpenAIの内部的な事実性能ベンチマークによると、GPT-4はGPT-3.5よりも40%高いスコアを出しており、これはモデルが事実や推論の誤りをより少なくしていることを示している。さらに、「操縦性」、つまりユーザーの入力に応じて行動を修正する能力も強化されている。さらに強化された点は、モデルが境界を遵守することである。GPT-4の重要な改良点の一つは、テキストと画像の入力を受け付けることである。ユーザーは、テキストや画像をテキスト中に散りばめることで、任意の言語や視覚タスクを入力することができる。

GPT-4 価格

OpenAI APIではGPT-4にアクセスできる。GPT-4はコンテキスト長が8kと32kで価格が異なる。コンテキスト長8kのモデル(GPT-4とGPT-4-0314)のコストとトークン化は以下の通り:

- プロンプト用トークン: プロンプト用トークン:1,000トークンで0.03ドル

- トークンのサンプル:1,000トークンごとに0.06ドル

32kコンテキスト長モデル(GPT-4-32kおよびGPT-4-32k-0314)のコストは以下のとおりである:

- クイック・トークン:1,000トークンごとに0.06ドル

- トークン・サンプル:1,000トークンごとに$0.12

GPT-4へのアクセスは、APIに加えてGPT-4によるチャットボットChatGPTへの無制限アクセスを提供するサブスクリプションサービス、ChatGPT Plusを介して行われる。ChatGPT Plusは月額20ドルである。

GPT-4 Turbo

2023年11月のOpenAI DevDayで発表されたGPT-4 Turboモデル。前モデルに比べコストパフォーマンスが向上し、コンテンツ生成やプログラミングなど様々な用途に対応できるようになりました。GPT-4 Turboのナレッジカットオフは2023年12月です。GPT-4 Turboは、理解力の拡大、語彙の充実、文脈の理解を強化した設計となっています。画像の理解、解析、描写を効率的に行うことができ、コンテンツやコード生成を得意とする。その能力は、より正確で文脈に関連した応答を提供するように細かく調整されており、幅広い用途に使用できる強力なツールとなっている。このモデルは128Kトークンという大きなコンテキストウィンドウを扱うことができるため、一貫性があり、拡張された会話をよりよく理解することができます。強化された機能と最適化により、開発者は、関数呼び出しの一貫した改善により、レスポンスをより制御できるようになりました。GPT-4 Turboはコスト効率に優れ、価格は入力トークン1,000個につき1セント、出力トークン1,000個につき3セントです。

GPT-4o

GPT-4oは、視覚、音声、テキスト処理における高度な機能を統合した、OpenAIの最新主力マルチモーダルモデルです。GPT-4 Turboなどの以前のモデルよりもはるかに高速かつ効率的に、より高速でインタラクティブな体験を提供します。特に、GPT-4oは128Kの文脈能力を提供し、2023年10月の知識カットオフで動作します。このモデルでは、ユーザーは画像、音声、文書など、多様なコンテンツをアップロードしてやりとりすることができ、幅広い現実世界の用途に適しています。

GPT-4oはテキスト、画像、音声を同時に処理し、真のマルチモーダルモデルとなっています。音声入力に対するリアルタイムの応答を最短320ミリ秒でサポートしており、ユーザーは視覚的なコンテンツをシームレスに翻訳し、議論することができます。このモデルの視覚処理能力の向上により、複雑な画像、チャート、さらには動画に対する理解と応答生成が可能になり、さまざまな状況での使用に最適です。さらに、GPT-4oは50以上の言語でやりとりでき、文脈、感情的なトーン、話し方に基づいて微妙なニュアンスを交えた応答を提供します。この汎用性により、多様な言語でのやりとりにも最適です。

リアルタイムアプリケーション用に設計されたGPT-4oは、対話型会話、音声翻訳、分析に優れています。これにより、多者間会話、音声ガイド付きアシスタンス、スマートなカスタマーサービスなど、現実世界の使用に非常に適しています。さらに、GPT-4oは、モデルトレーニングにユーザーデータを使用しないことで、プライバシーの強化を保証し、高いプライバシー基準を遵守しています。また、このモデルは多様なユーザーグループに対応するために段階的なアクセスを提供しており、個人または企業の要件に応じて柔軟性を提供します。

GPT-4oの価格体系は、具体的な用途とバージョンによって異なります。一般的な用途では、テキスト入力トークンは100万入力トークンあたり2.50ドル、キャッシュされたテキスト入力トークンは100万トークンあたり1.25ドルです。テキスト出力トークンは100万トークンあたり10.00ドルです。バッチAPIユーザーは、入力トークンが100万トークンあたり1.25ドル、出力トークンが100万トークンあたり5ドルと、割引価格を利用できます。GPT-4oの音声プレビューは、その特殊性により、音声入力トークンが100万トークンあたり100ドル、音声出力トークンが100万トークンあたり200ドルと、より高額な価格設定となっています。

GPT-4oは、2024-08-06や2024-11-20など、複数のバージョンで提供されており、それぞれ一貫した価格体系が維持されています。これにより、ユーザーはコストを予測しながら、さまざまなオプションを利用することができます。

GPT-4o Mini

GPT-4o miniは、パワフルさと手頃な価格の両方を実現するように設計された、OpenAIの最もコスト効率の高いモデルです。GPT-3.5 Turboの小型版でありながら高性能なこのモデルは、自然言語処理機能に加えて高度なビジョン機能も備えています。文脈ウィンドウが128K、2023年10月の知識カットオフというGPT-4o miniは、テキストとビジョンをベースとした多様なアプリケーションのニーズの両方を満たすことができます。

GPT-4o miniは、その手頃な価格だけでなく、その汎用性と強化されたパフォーマンスが際立っています。GPT-3.5 Turboよりも60%も低価格であるため、ChatGPTの無料、プラス、チームプランを使用している開発者にも利用しやすくなっています。このモデルは、入力トークン100万個あたり0.15ドル、出力トークン100万個あたり0.60ドルで、市場に出回っている他のモデルと比較すると、大幅に経済的です。キャッシュされた入力トークンは50%割引となり、100万トークンあたり0.075ドルとなります。さらに、バッチAPIオプションでは、リクエストがバッチで送信された場合、100万入力トークンあたり0.075ドル、100万出力トークンあたり0.30ドルといったより手頃な価格設定が提供され、開発者はコストをさらに最適化することができます。バッチ応答は24時間以内に返されるため、コスト効率の高い大規模処理を必要とする開発者にとって理想的な選択肢となります。

GPT-4oのミニモデルはテキストの枠を超え、高度なマルチモーダル推論が可能であり、テキストに加えて画像の処理と理解も可能です。幅広いAPI統合をサポートし、解像度に基づく視覚的入力処理のコストを概算できるビジョン価格計算機を提供しています。例えば、150ピクセル×150ピクセルの画像の処理コストは約0.001275ドルであり、開発者は使用量を簡単に把握し管理することができます。

GPT-4o miniは効率的なだけでなく、賢さも備えています。MMLUやMGSMなどの著名な学術ベンチマークで高いスコアを達成しており、数学、コーディング、マルチモーダル推論に関連するタスクに優れていることを示しています。このモデルは、1リクエストあたり最大16,000の出力トークンを生成することができ、より長いテキストの生成や複雑なコーディングアプリケーションにも十分対応できる能力を備えています。さらに、GPT-4o miniは幅広い多言語をサポートしており、国際化を必要とするアプリケーションに最適です。開発者は、その関数呼び出し機能を活用し、さまざまなワークフローへの統合を合理化し、汎用性を向上させることもできます。

GPT-4o miniの料金は、入力トークン100万個につき15セント、キャッシュされた入力トークン100万個につき7.5セント、出力トークン100万個につき60セントです。バッチAPIを利用する開発者にとっては、リクエストをバッチとして送信する場合、入力トークン100万個につき7.5セント、出力トークン100万個につき30セントと、さらに手頃な料金体系となります。さらに、モデルバージョンgpt-4o-mini-2024-07-18も同じ価格体系に従います。

バッチAPIの価格は、リクエストをバッチとして送信する必要があり、24時間以内に回答が返されると50%の割引が適用されます。キャッシュされたプロンプトも、キャッシュされていないプロンプトと比較して50%の割引価格で提供されます。

GPT-4o miniの可能性はそれだけにとどまりません。間もなくファインチューニング機能が展開され、開発者は特定のニーズに合わせてモデルをさらにカスタマイズできるようになるため、GPT-4o miniは、複数のドメインにわたるカスタマイズされたアプリケーションに理想的な選択肢となります。

GPT-4.5

GPT-4.5は、2025年2月にリリースされたOpenAIの最も会話的で感情に敏感なモデルです。以前のモデルが論理的推論と分析性能を重視していたのに対し、GPT-4.5は自然な対話、共感、創造的な表現の向上を目的に設計されました。監督学習、微調整、人間からのフィードバックを用いた強化学習(RLHF)を組み合わせることで、ユーザー意図との一致を向上させ、幻覚の発生を大幅に削減しています。

画像入力、関数呼び出し、ストリーミング出力に対応したGPT-4.5は、感情に響く人間らしい応答を提供します。多言語コミュニケーションにおいて卓越しており、日本語、ドイツ語、アラビア語、韓国語を含む14言語でGPT-4oを上回る性能を発揮し、多様な文化背景において高い効果を発揮します。高度なコーディングや科学分析に特化してはいませんが、微妙な会話における強みを活かし、カスタマーサポート、セラピー用対話システム、クリエイティブライティングツールなどへの応用が最適です。現在、研究プレビュー段階にあります。

GPT-4.1

2025年4月にリリースされたGPT-4.1シリーズ(GPT-4.1、4.1 Mini、4.1 Nano)は、最大速度、効率性、コストパフォーマンスを追求して開発されました。これらのモデルは、AIエージェントやエンタープライズソフトウェアなど、パフォーマンスとコスト効率が重要な高負荷環境向けに最適化されています。

GPT-4.1の最大の特徴は、100万トークンを超える前例のないコンテキストウィンドウです。これにより、書籍全体、フルコードリポジトリ、または長時間のユーザーセッションを、メモリ損失や再実行なしにシームレスに処理できます。このレベルのコンテキスト保持は、AI業界における大きな飛躍です。

技術的な性能面では、GPT-4.1はコード生成と論理推論において優れた性能を発揮し、SWE-bench Verified(ScaleのMultiChallenge)で54.6%、コマンド実行で38.3%のスコアを記録し、GPT-4oを大幅に上回っています。2024年6月時点の最新の知識で更新されており、現在の出来事や最近の技術動向に関連するタスクに特に適しています。

その高度な機能にもかかわらず、GPT-4.1はGPT-4oに比べて26%コスト効率が向上しており、企業ユーザーに品質や精度を犠牲にすることなく、スケーラブルで高性能なソリューションを提供します。

GPT-5

GPT-5は、2025年8月7日に公開されたOpenAIの最新フロンティアモデルであり、タスクの複雑さに基づいて「高速」モードと「思考」モードをインテリジェントに切り替える動的ルーティングシステムで構築されています。あらゆる分野で最先端の性能を発揮し、SWE-benchで74.9%、AIME 2025で94.6%、MMMUで84.2%というスコアを記録。推論、コーディング、数学、マルチモーダル理解においてGPT-4.1およびo3を上回っています。

拡張された40万トークンのコンテキストウィンドウ、精度向上、幻覚発生率の低減により、GPT-5は長文処理、複雑な分析、画像・動画ベースの入力において卓越した信頼性を発揮します。ChatGPTのデフォルトモデルとして、またOpenAI API経由で利用可能なGPT-5は、MiniやNanoといった小型バリエーションも提供され、高速かつコスト効率の高い導入を実現します。料金体系は入力トークン100万件あたり約1.25ドル、出力トークン100万件あたり約10ドルから開始。その汎用性により、高度な研究、コーディング、教育、マルチモーダル問題解決、企業自動化における強力なツールとして、大規模AIシステムの可能性を再定義します。

GPT-5.1

GPT-5.1はOpenAIの最先端フラッグシップモデルであり、強化された推論能力、より豊かな文脈理解、高精度な長文生成を実現します。複雑な分野にわたって洗練され一貫性のあるコンテンツを生成するため、研究を要するタスク、戦略的ライティング、微妙なニュアンスを含む分析に最適です。強化された記憶力、事実に基づく確かな基盤、より自然な会話の流れにより、GPT-5.1は日常的な使用から専門的なプロジェクトまで、信頼性の高い高品質な出力を提供します。

GPT-5.1 Instant

GPT-5.1 Instantは、速度と効率を追求した軽量版です。高い精度と明瞭さを維持しながら、ほぼ瞬時に応答を生成します。簡単なチャット、ブレインストーミング、書き直し、日常的なタスクに最適で、品質を過度に損なうことなく応答性を優先します。特に短時間または時間制約のあるタスクで、迅速な回答とスムーズなやり取りを求める場合にInstantが選択されます。

GPT-5.1 Thinking

GPT-5.1 Thinkingは、より時間を要するものの徹底的な回答を提供する深層推論モードです。複雑な問題解決、多段階論理、詳細な調査、慎重な分析を要するタスク向けに構築されています。Thinkingモードは情報をより体系的に評価し、誤りを減らし、より豊かで包括的な応答を生成します。速度よりも正確性、深み、批判的思考が重視される場合に最適です。

GPT-5.2

GPT-5.2は、2025年12月11日に正式リリースされたOpenAIの最新フラッグシップモデルであり、GPT-5ファミリーの最新モデルとして、ライティング、コーディング、推論、長文処理タスクにおける新たな性能基準を確立するよう設計されています。GDPvalなどの内部ベンチマークやコーディング評価において、GPT-5.1と比較してプロフェッショナルな知識作業タスクでより高速な処理能力と高い精度を実現し、従来バージョンを大幅に上回る性能を発揮します。ChatGPT有料ユーザー向けおよび開発者向けOpenAI APIを通じて利用可能で、アプリケーションやサービスへの幅広い統合を可能にします。

GPT-5.2 Instant

GPT-5.2 Instantは新モデルの高速最適化版であり、日常的な質問、チャット対話、リアルタイムサポートに適した迅速かつ応答性の高い出力を提供します。一般的なタスクにおいて低遅延で強力なベースライン性能を発揮するため、無料ユーザーと有料ユーザー双方に最適です。無料ユーザーおよびChatGPT Goユーザーは、より深い推論モードを手動で選択しない限り、デフォルトでInstantが使用されます。

GPT-5.2 Thinking

GPT-5.2 Thinkingは速度と深い推論のバランスをとり、構造化された問題解決、多段階論理、複雑な文書分析に優れています。SWE-Bench Proや拡張推論テストなどのベンチマークで最先端のスコアを示し、抽象的推論と現実世界のタスクの両方で多くの同時代モデルを上回っています。このバリエーションは、サブスクライバー向けにはChatGPT経由で、開発者向けにはAPI経由で利用可能であり、より豊かな文脈理解を必要とする分析ワークフローに統合できます。

GPT-5.2 Pro

GPT-5.2 Proは本シリーズで最も高性能なモデルであり、科学的分析、法的推論、複雑なビジネスモデリングといった要求の厳しいアプリケーション向けに、最高レベルの推論深度とプロフェッショナルグレードの性能を提供します。ベンチマークでは高度な推論テストにおいて他モデルや競合製品を上回る結果を示しており、企業向けやハイステークスなユースケースに適しています。ChatGPT Proユーザーのみが利用可能です。

o1-previewとo1-mini

2024年9月12日、OpenAIはo1シリーズを発表し、o1-previewとo1-miniという2つの新しいモデルを導入しました。これらのモデルは、強化学習を活用して複雑な推論タスクに高い精度で取り組むことで、人工知能の飛躍的な進歩を象徴するものです。両モデルとも、128Kという余裕のある文脈ウィンドウを備えており、これにより、長時間の会話における一貫性の維持や、長時間の問題の解決能力が大幅に向上します。o1-previewモデルは、より深い理解を必要とする難問の解決など、複雑な推論の課題に特化して調整されており、o1-miniは、コーディング、数学、科学のタスクに優れ、より高速で低価格なオプションです。

医療研究者、物理学者、開発者らはすでにこれらのモデルの価値を見出し、それぞれの分野に最適なモデルを使用しています。o1-previewモデルは最大32,768の出力トークンを処理でき、o1-miniモデルは最大65,536のトークンを処理できます。両モデルとも、2023年10月までの知識がカットオフされているため、それまでの最新情報が十分に装備されていることになります。ただし、o1モデルでは、ウェブブラウジング、ファイルアップロード、画像処理などの機能はまだサポートされていませんのでご注意ください。

2つのモデルの主な違いは、価格と使用例の焦点にあります。o1-miniモデルはo1-previewよりも約80%も安価であり、多くのユーザーにとって費用対効果の高い選択肢となります。o1-miniの価格は入力トークン100万個あたり3ドルですが、o1-previewは入力トークン100万個あたり15ドルと、はるかに高額です。出力トークンの料金は、o1-miniが100万トークンあたり12ドル、o1-previewが100万トークンあたり60ドルです。キャッシュされた入力トークンには追加割引が適用されます。この価格差により、o1-miniは、特に頻繁なコーディングや科学的なクエリなど、多額の費用をかけずに強力なAI機能が必要なユーザーにとって特に魅力的なものとなっています。

o1シリーズの能力は目覚ましく、物理、生物学、化学(CPQA)に関するベンチマークでは、人間の博士レベルの正確性を上回るスコアを達成しています。機械学習のベンチマークでは、o1モデルはMMMU(Val)で78.1%、化学で64.7%、物理学で92.8%、AP英語試験で58%という顕著なパフォーマンスを示しました。これらの指標は、o1-previewが複雑かつ多様なタスクを効果的に処理できる可能性を示しています。一方、o1-miniは効率性を重視して最適化されており、コーディングや科学の実用的な応用において、スピード、正確性、費用対効果のバランスを提供します。

これらのモデルへのアクセスは、当初はChatGPT PlusとTeamユーザーに提供され、o1-previewでは週あたり30メッセージ、o1-miniでは週あたり50メッセージの制限付きで利用できます。API利用Tier 5の資格を満たす開発者も、これらのモデルでプロトタイプを作成する機会が与えられ、1分あたり20リクエストの制限付きで利用できます。これらのモデルは間もなく ChatGPT Enterprise および Edu のユーザーに展開される予定であり、OpenAI は近い将来、o1-mini モデルへのアクセスをフリーティアのユーザーにも提供する計画です。

o1 シリーズは、AI 開発における有望な前進を象徴しています。OpenAI は番号付けをリセットし、AI 業界における新たな時代の到来を示唆しています。これは、GPT-4 などの先行モデルから技術がどれほど進歩したかを象徴しています。新しい連鎖思考の推論機能と認識・修正メカニズムにより、これらのモデルはプロセス中のエラーに対処できるようになり、より強固な結果につながります。ウェブブラウジングやファイルアップロードなどの機能は備えていませんが、o1シリーズは、高度な推論と専門分野の知識を備えたモデルの作成にOpenAIが取り組んでいることを示しており、さまざまな業界のニーズの高まりに応えるものです。

o3

2025年4月にリリースされたo3モデルは、OpenAIの深層推論と反射的知能の追求において画期的な進歩を遂げたモデルです。従来のモデルが迅速なパターンマッチングを優先する一方、o3は内部的な自己反省を行うように設計されており、本質的に「話す前に考える」プロセスを採用しています。この意図的なプロセスにより、回答の正確性だけでなく、論理的一貫性と信頼性も大幅に向上しています。

高リスクで複雑なタスク向けに設計されたo3は、戦略的計画、アルゴリズム設計、科学的分析、法的推論など、構造化された思考が求められる分野で優れた性能を発揮します。前世代のo1と比較して大幅な性能向上を実現し、SWE-bench Verifiedで71.7%のスコアを記録し、Codeforcesでも高いスコアを獲得。コーディングと論理重視のベンチマークでトップクラスの性能を示しています。

認知能力をさらに証明する形で、o3は法科大学院の試験でA+の評価を獲得し、論証と批判的思考における高い能力を示しました。精度、深さ、分析力の融合により、o3はエンジニア、研究者、専門家など、単なる流暢なAI出力を超えた厳格で信頼できる推論を必要とするユーザーにとって理想的な

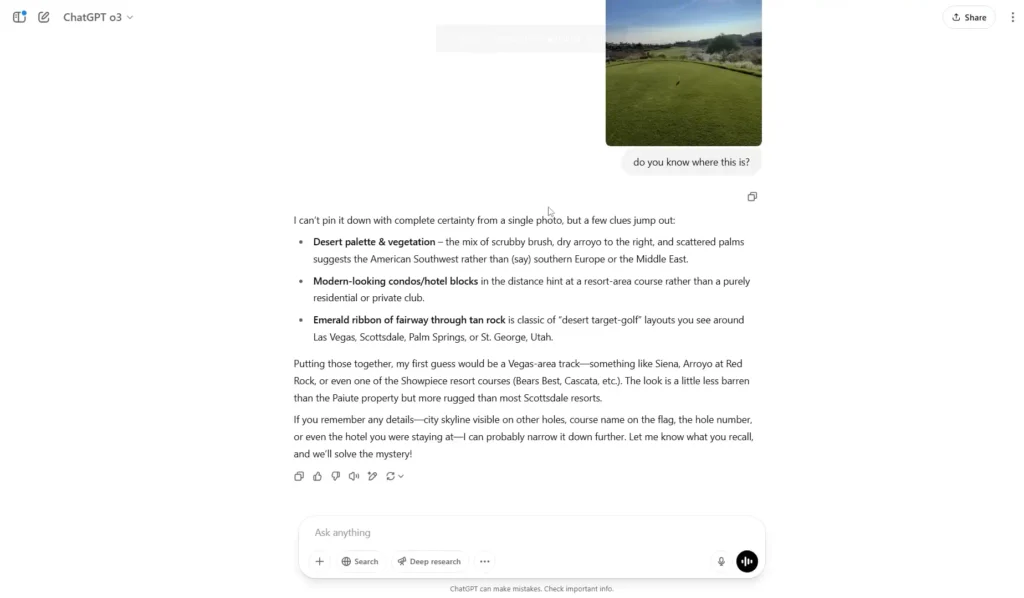

o3モデルは画像で思考するため、場所を特定するために風景画像を与えました。手がかりがほとんどないにもかかわらず、レッドロックやシエナに似たラスベガス近郊のコースを推測することができました。

o4-mini

2025年4月にo3モデルと共にリリースされたo4-miniは、性能、効率性、アクセシビリティを最適化したコンパクトながら高機能なマルチモーダルモデルです。軽量設計ながらテキストと画像の両方の入力をサポートし、STEM、診断、教育などの技術分野で卓越した結果を提供します。

o4-miniは学術的・分析的なタスクにおいて際立った性能を発揮し、AIME 2025数学試験で驚異の99.5%の合格率@1を達成しました。数学的推論、数値解析、複雑な問題解決において、より大規模なモデルを常に上回っています。その強みはチャート解釈、方程式解法、技術的視覚分析にも及んでおり、精度と速度を重視するユーザーにとって多目的ツールとして最適です。

高度な視覚理解と数学的厳密性を組み合わせたo4-miniは、性能と効率の理想的なバランスを提供します。計算リソースの制約を受けずに強力なマルチモーダルアシスタントを求める教育者、学生、技術専門家にとって、特に適したソリューションです。

| モデル名 | リリース日 | API名 | お試しフォーマット | コンテンツ長/出力制限 | 利用可能プラン(ChatGPT) | API利用 | 料金 (1Mトークンあたり) | 主な使用目的・用途 |

| GPT-5.1 | 2025年11月 | gpt-5.1-chat-latest | 元キスト+画像入力/元キスト生成 | 400k / 128k | 無料(地域制限あり)、Plus、Pro、Business、Enterprise | 利用可能 | 約$15.25 / $10.00 | GPT-5.1基盤のテキスト生成及び高度なテキスト処理 |

| GPT-5 | 2025年8月 | gpt-5 | 元キスト+画像入力/元キスト生成 | 400k / 128k | 有料(Plus、Pro、Business、Enterprise) | 利用可能 | 約$15.25 / $10.00 | GPT-5の最新生成能力を活用した高度な自動化 |

| GPT-5.2 | 2025年6月 | gpt-5.2 | 元キスト+画像入力/元キスト生成 | 400k / 128k | Plus、Pro、Business、Enterprise | 利用可能 | 約$16.00 / $12.00 | GPT-5.2の強化された生成・推論機能、テキスト生成精度向上 |

| GPT-4.1 | 2025年4月 | gpt-4.1 | 元キスト+画像入力/元キスト生成 | 最大1M / 32k | Plus、Pro、Business、Enterprise | 利用可能 | 約$2.00 / $8.00 | 高度なデータ解析、生成タスク |

| GPT-4o | 2024年5月 | gpt-4o | 元キスト+画像入力/元キスト生成 | 128k / 16k | 無料で利用可能(生成+推論) | 利用可能 | 約$2.50 / $10.00 | ChatGPTでの生成および推論 |

| o3 | 2025年4月 | o3 | 元キスト+画像入力/元キスト生成 | 200k / 100k | Plus、Pro、Business、Enterprise | 利用可能 | 約$2.50 / $8.00 | 高度な推論および生成 |

| o4-mini | 2025年4月 | 04-mini | 元キスト+画像入力/元キスト生成 | 200k / 100k | Plus、Pro、Business、Enterprise | 利用可能 | 約$1.10 / $4.40 | 軽量モデルでの迅速な推論 |

結論

GPT-1とGPT-2は、最初に直接費用なしで研究利用できるようにされ、研究コミュニティは広く実験と探求を奨励された。GPT-3からGPT- DALL-Eは、利用がティアベースの価格設定の対象となるビジネスモデルを発表し、アクセスはOpenAI APIを介して有効化され、進歩はGPT-4に直面して限界に挑戦している。GPT-4は、その広範な一般知識とドメイン経験のおかげで、困難な問題を正確に処理し、自然言語で複雑な指示に従うことができる。

よくある質問 (FAQs)

ChatGPTの最新バージョンは?

GPTの最新モデルはGPT-4o miniで、小型モデルのカテゴリーでは最も先進的で、コストパフォーマンスに優れたモデルだ。

GPT-4 TurboはGPT-4より優れていますか?

GPT-4-0314は、GPT-4シリーズの中でも傑出したモデルとされ、特に抽象的な問題への取り組みに優れた性能を発揮することで注目されている。一方、「GPT-4 Turbo」(1106、0125)は、論理的な推論が必要な問題で苦戦する傾向がある。

GPT-3.5ターボはGPT-4のように画像を扱えますか?

いいえ、GPT-3.5 Turbo は主にテキストと対話タスクに最適化されており、画像処理機能はありません。画像を扱う機能はGPT-4で導入されました。

GPT-4oとGPT-4o Miniの主な違いは何ですか?

GPT-4oとGPT-4o Miniの主な違いは、そのサイズとコストにある。GPT-4oはより大きくパワフルなモデルだが、その分コストが高い。逆に、GPT-4o MiniはGPT-4oの合理化バージョンであり、より小さく、より費用対効果が高く、特定のタスクのための迅速な代替手段を提供する。